NVIDIA GTC(GPU Technology Conference)는 매년 AI와 컴퓨팅 기술의 미래를 엿볼 수 있는 중요한 행사입니다. 2025년 행사를 앞두고 궈밍치 애널리스트의 예측을 바탕으로 NVIDIA의 차세대 기술과 전략을 살펴보겠습니다. B300 GPU, 첨단 냉각 기술, CoWoS 패키징 기술 등 NVIDIA가 선보일 혁신적인 기술들은 AI 시대의 새로운 표준을 제시할 것으로 기대됩니다.

방금 나온 NVIDIA GTC 2025 … 궈밍치 예측 젠슨황 기조연설 나올 내용의 의미 | 앞으로의 AI 시대와 NV

이 영상은 NVIDIA GTC 2025에서 발표될 내용들을 궈밍치 애널리스트의 예측을 바탕으로 분석하고, **AI 시대의 흐름과 NVIDIA의 전략**을 전망합니다. B300 GPU, 액체 냉각 기술, CoWoS 패키징 기술 등 **핵심

lilys.ai

B300 GPU: AI 컴퓨팅의 새로운 지평

성능과 메모리 향상의 획기적 진전

B300 시리즈는 이전 세대 대비 50% 향상된 성능과 128GB에서 192GB로 증가한 메모리 용량을 자랑합니다. 이러한 발전은 AI 모델이 계속해서 커지고 복잡해지는 현 시점에서 매우 중요한 의미를 갖습니다. 특히 스케일링 법칙에 따르면 컴퓨팅 자원의 증가가 AI 성능 향상에 직접적인 영향을 미치는데, B300은 이러한 요구에 완벽하게 부응하는 제품이라 할 수 있습니다.

최신 반도체 기술 동향을 살펴보면, 단일 칩에 더 많은 트랜지스터를 집적하는 것이 점점 어려워지면서 고급 패키징 기술을 활용한 멀티칩 설계가 주목받고 있습니다. 이러한 접근 방식은 현재의 제조 공정을 크게 방해하지 않으면서도 계산 능력을 계속 늘릴 수 있는 새로운 경로를 제시합니다.

듀얼 다이와 싱글 다이 아키텍처

B300 서버는 듀얼 다이와 싱글 다이를 모두 지원하는 혁신적인 시스템 솔루션을 제공합니다. 듀얼 다이 접근 방식은 두 개의 칩을 병렬로 연결하여 연산 성능을 크게 향상시키는 방식으로, 대규모 AI 워크로드 처리에 최적화되어 있습니다.

이러한 접근 방식은 최근 연구에서 언급된 'Composable On-Package Architecture(COPA)'의 개념과 유사한데, 이는 멀티칩 모듈 분해를 활용하여 최대한의 설계 재사용을 지원하고 애플리케이션 도메인별로 메모리 시스템을 특화시키는 방식입니다. 이 기술은 기준 GPU 아키텍처를 모듈식으로 보강하여 4배 높은 다이 외부 대역폭, 32배 더 큰 온패키지 캐시, 2.3배 높은 DRAM 대역폭과 용량을 제공할 수 있습니다.

혁신적인 패키징 기술: CoWoS의 진화

CoWoS 기술의 중요성

NVIDIA의 데이터센터 GPU는 TSMC의 CoWoS(Chip-on-Wafer-on-Substrate) 패키징 기술에 크게 의존하고 있습니다. 이 기술은 "chip-last" 어셈블리 플로우를 위한 것으로, 여러 칩을 효율적으로 연결하여 회로를 구성하는 방식입니다.

CoWoS는 TSMC의 저전압 패키지 인터커넥트(LIPINCON)와 함께 핀당 최대 8Gb/s의 데이터 전송률을 제공할 수 있어, 고성능 AI 워크로드에 필수적인 높은 대역폭 요구사항을 충족시킵니다. 하지만 HBM과 인터포저 생산에서 수율 저하 문제가 지적되고 있으며, 큰 HBM을 사용하기 위한 대규모 인터포저 생산이 점점 어려워지고 있습니다.

인터포저 기술의 진화: 코어스 L과 R

코어스 L은 TSMC의 InFO(Integrated Fan-Out) 기술과 결합하여 더 효율적인 설계를 지향하고 있습니다. InFO는 "chip-first" 어셈블리 플로우를 위한 것으로, RDL(재분배 층)을 기판으로 사용하여 MCM보다 더 작은 라인 공간을 제공합니다.

기존의 실리콘 인터포저 방식 대신 FANOUT RDL 인터포저가 사용될 가능성도 있으며, 이는 생산 효율성을 높이고 수율 문제를 해결하는 데 도움이 될 수 있습니다. 이러한 기술적 변화는 B300 GPU의 성능을 최대화하고 생산 비용을 최적화하는 데 중요한 역할을 할 것입니다.

냉각 기술의 혁신: 액체 냉각과 액침 냉각

냉각 방식의 종류와 특징

최신 GPU의 높은 성능은 더 많은 열을 발생시키므로, 효율적인 냉각 기술이 필수적입니다. NVIDIA는 다양한 냉각 방식을 활용하고 있습니다:

- 공랭식 냉각: 선풍기를 통해 열을 식히는 전통적인 방식

- 액체 냉각: 특별한 액체가 열을 빠르게 받아들여 바깥으로 내보내는 방식

- 액침 냉각(Immersion Cooling): 전기가 통하지 않는 비전도성 물질에 칩을 담가 열을 빨리 식히는 기술

특히 액침 냉각은 열을 신속하게 식힐 수 있는 효율적인 방법이지만, 데이터 센터에 도입하기 위해서는 건물 구조를 변경해야 하는 등 인프라 변경이 필요하기 때문에 실용적 도입에는 제약이 따릅니다.

Lite-GPU와 냉각 효율성

흥미로운 개념 중 하나는 Lite-GPU인데, 이는 단일 소형 다이와 더 큰 GPU의 일부 기능만 갖춘 GPU를 의미합니다. Lite-GPU를 사용하면 랙당 장치 수는 증가하지만 단위 면적당 에너지는 감소하며, 더 효율적인 냉각 가능성을 제공합니다.

이러한 접근 방식은 데이터 센터에서 상당한 공간을 차지하는 액체 냉각 랙의 필요성을 줄이는 데 도움이 될 수 있으며, 특히 공동 패키징된 광학 기술과 결합할 때 더욱 효과적입니다.

FP4 연산과 AI의 미래

FP4의 중요성과 응용

FP4는 아직 널리 사용되지 않지만, 로직과 트랜스포머 엔진의 새로운 배치로 성능 증가가 기대됩니다. NVIDIA는 하드웨어 설계 및 제조에 2~3년이 소요되므로, 미래 수요에 미리 대응하기 위해 FP4와 같은 저정밀도 연산 기능을 준비하고 있습니다.

최근의 GPU 설계 동향을 살펴보면, 딥러닝 성능을 향상시키기 위해 저정밀도 행렬 수학 처리량을 늘리는 추세가 있습니다. 딥러닝 워크로드는 주로 FP16(또는 더 작은) 기반이고, HPC 워크로드는 FP32(또는 더 큰) 기반인 것으로 알려져 있습니다.

AI 모델 발전과 하드웨어 요구사항

AI 모델이 급변하는 가운데, FP4와 같은 하드웨어를 미리 준비하는 것은 NVIDIA의 전략적 선택입니다. FP4는 주로 추론 시장에서 사용되고 있으며, NVIDIA는 이를 통해 경쟁 시장에서의 점유율을 보호하고자 합니다.

기존 GPU 설계에서 벗어나 도메인 특화된 GPU 제품을 제공하는 접근 방식은 FP32(또는 더 큰) 기반 HPC와 FP16(또는 더 작은) 기반 딥러닝 워크로드 간의 다양한 아키텍처 요구 사항을 해결하기 위한 실용적인 솔루션으로 주목받고 있습니다.

데이터 센터 인프라의 변화

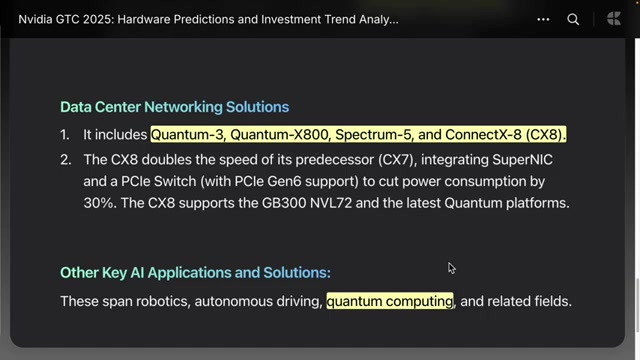

네트워크 솔루션과 PCI Gen 6

NVIDIA의 퀀텀 시리즈 데이터 센터 네트워크 솔루션은 PCI Gen 6를 지원하며, 이는 다양한 데이터 통신을 가능하게 합니다. PCI Express는 CPU와 GPU 간의 통신에서 필요한 약속을 제공하며, 데이터 전송 속도의 표준을 설정하는 중요한 역할을 합니다.

최신 연구에 따르면, 인패키지 광학 인터커넥트의 발전으로 인패키지 인터커넥트 대역폭이 계속해서 증가할 것으로 예상됩니다. 이는 컴퓨터 아키텍처 관점에서 가용 칩 간 대역폭과 이를 활용하는 능력 사이에 불일치가 발생할 수 있음을 의미합니다.

공동 패키징된 광학 기술의 중요성

공동 패키징된 광학(Co-packaged Optics) 기술을 통해 향후 10년 동안 패키지 외부 통신 대역폭이 1-2배 향상될 것으로 예상됩니다. 이 기술은 현재의 플러그형 광학과 달리 전자 및 광학 구성 요소를 밀리미터 내에 통합하여 신호 거리를 단축하고 더 나은 전력 효율성을 제공합니다.

퀀텀 컴퓨팅과의 협력 가능성

NVIDIA는 쿠다큐라는 시스템을 통해 쿠다 퀀텀 시스템을 구축하고 있으며, 이는 다양한 플랫폼에서 지원할 수 있도록 설계되어 있습니다. GTC 행사에서는 여러 퀀텀 컴퓨팅 관련 기업들이 참가하여 자신들의 기술을 소개하고, 하이브리드 컴퓨팅의 중요성을 강조할 것으로 예상됩니다.

NVIDIA는 기존 컴퓨팅의 빠른 처리 부분을 퀀텀 컴퓨터가 담당하도록 지원할 입장이며, 이를 통해 특정 연산에서 획기적인 성능 향상을 기대할 수 있습니다. 향후 로보틱스와 같은 기술들도 이러한 시스템을 바탕으로 발전할 가능성이 높습니다.

결론: NVIDIA의 미래 전략과 AI 시장 리더십

NVIDIA는 B300 GPU, 혁신적인 냉각 기술, 고급 패키징 기술, FP4 연산, 데이터 센터 인프라 변화 등을 통해 AI 시장에서의 리더십을 더욱 강화할 것으로 예상됩니다. 이러한 기술적 혁신은 단순히 성능 향상을 넘어 AI 생태계 전체의 패러다임을 변화시킬 잠재력을 가지고 있습니다.

특히 주목할 점은 NVIDIA가 단순히 현재의 수요에 대응하는 것이 아니라, 2-3년 후의 미래 수요를 예측하고 이에 미리 대응하는 선제적 전략을 취하고 있다는 것입니다. 이러한 접근 방식은 급변하는 AI 기술 환경에서 NVIDIA가 지속적인 경쟁 우위를 유지할 수 있는 핵심 요소가 될 것입니다.

결론적으로, NVIDIA GTC 2025는 단순한 신제품 발표 행사를 넘어, AI 기술의 미래와 컴퓨팅 패러다임의 변화를 엿볼 수 있는 중요한 이정표가 될 것으로 기대됩니다. 이 행사를 통해 발표될 혁신적인 기술들은 우리가 컴퓨팅과 AI를 바라보는 방식을 근본적으로 변화시킬 것입니다.

NVIDIA GTC 2025 Preview: Game Changers in the AI Era, B300 GPU and Innovative Technologies

NVIDIA GTC (GPU Technology Conference) is an important annual event that offers a glimpse into the future of AI and computing technologies. Based on analyst Guo Mingchi's predictions ahead of the 2025 event, we'll explore NVIDIA's next-generation technologies and strategies. Innovative technologies that NVIDIA will showcase, such as the B300 GPU, advanced cooling technologies, and CoWoS packaging technology, are expected to set new standards in the AI era.

B300 GPU: A New Horizon in AI Computing

Breakthrough Advancements in Performance and Memory

The B300 series boasts 50% improved performance and memory capacity increased from 128GB to 192GB compared to the previous generation. These advancements are highly significant at a time when AI models continue to grow larger and more complex. According to scaling laws, increased computing resources directly impact AI performance improvement, and the B300 can be considered a product that perfectly meets these demands.

Looking at the latest semiconductor technology trends, as it becomes increasingly difficult to integrate more transistors onto a single chip, multi-chip designs utilizing advanced packaging technologies are gaining attention. This approach presents a new path to continue increasing computational power without significantly disrupting current manufacturing processes.

Dual Die and Single Die Architecture

The B300 server offers an innovative system solution that supports both dual die and single die architectures. The dual die approach significantly enhances computational performance by connecting two chips in parallel, optimized for processing large-scale AI workloads.

This approach is similar to the concept of 'Composable On-Package Architecture (COPA)' mentioned in recent research, which utilizes multi-chip module disaggregation to support maximum design reuse and specializes memory systems by application domain. This technology can provide 4x higher off-die bandwidth, 32x larger on-package cache, and 2.3x higher DRAM bandwidth and capacity by modularly augmenting the baseline GPU architecture.

Innovative Packaging Technology: Evolution of CoWoS

Importance of CoWoS Technology

NVIDIA's data center GPUs heavily rely on TSMC's CoWoS (Chip-on-Wafer-on-Substrate) packaging technology. This technology is designed for "chip-last" assembly flow, efficiently connecting multiple chips to form circuits.

CoWoS, along with TSMC's low-voltage package interconnect (LIPINCON), can provide data transfer rates of up to 8Gb/s per pin, meeting the high bandwidth requirements essential for high-performance AI workloads. However, yield reduction issues have been pointed out in HBM and interposer production, and large-scale interposer production for large HBM usage is becoming increasingly difficult.

Evolution of Interposer Technology: Cores L and R

CoWoS L aims for more efficient design by combining with TSMC's InFO (Integrated Fan-Out) technology. InFO is designed for "chip-first" assembly flow, using an RDL (redistribution layer) as a substrate to provide smaller line space than MCM.

There's also the possibility of using FANOUT RDL interposers instead of traditional silicon interposer methods, which can help improve production efficiency and solve yield issues. These technological changes will play a crucial role in maximizing the performance of the B300 GPU and optimizing production costs.

Innovations in Cooling Technology: Liquid Cooling and Immersion Cooling

Types and Characteristics of Cooling Methods

The high performance of the latest GPUs generates more heat, making efficient cooling technologies essential. NVIDIA utilizes various cooling methods:

- Air cooling: Traditional method of cooling through fans

- Liquid cooling: Method where special liquid quickly absorbs and expels heat

- Immersion cooling: Technology that rapidly cools chips by immersing them in non-conductive material

Immersion cooling, in particular, is an efficient method for rapidly dissipating heat, but practical adoption is constrained by the need for infrastructure changes, such as modifying building structures to introduce it into data centers.

Lite-GPU and Cooling Efficiency

One interesting concept is the Lite-GPU, which refers to a GPU with a single small die and only some of the capabilities of a larger GPU. Using Lite-GPUs increases the number of devices per rack but decreases energy per unit area, offering more efficient cooling possibilities.

This approach can help reduce the need for liquid-cooled racks that occupy significant space in data centers, and is particularly effective when combined with co-packaged optics technology.

FP4 Computation and the Future of AI

Importance and Applications of FP4

Although FP4 is not yet widely used, performance increases are expected from new arrangements of logic and transformer engines. NVIDIA is preparing low-precision computation capabilities like FP4 to proactively respond to future demands, as hardware design and manufacturing takes 2-3 years.

Looking at recent GPU design trends, there is a tendency to increase low-precision matrix math throughput to enhance deep learning performance. Deep learning workloads are primarily based on FP16 (or smaller), while HPC workloads are known to be based on FP32 (or larger).

AI Model Development and Hardware Requirements

As AI models rapidly evolve, preparing hardware like FP4 in advance is NVIDIA's strategic choice. FP4 is primarily used in the inference market, and NVIDIA aims to protect its market share in competitive markets through this.

The approach of providing domain-specialized GPU products that deviate from traditional GPU designs is gaining attention as a practical solution to address the diverse architectural requirements between FP32 (or larger) based HPC and FP16 (or smaller) based deep learning workloads.

Changes in Data Center Infrastructure

Network Solutions and PCI Gen 6

NVIDIA's Quantum series data center network solutions support PCI Gen 6, enabling various data communications. PCI Express plays a crucial role in providing necessary protocols for communication between CPUs and GPUs and setting standards for data transfer speeds.

According to recent research, in-package interconnect bandwidth is expected to continue increasing with advancements in in-package optical interconnects. From a computer architecture perspective, this means there could be a mismatch between available inter-chip bandwidth and the ability to utilize it.

Importance of Co-packaged Optics Technology

Through co-packaged optics technology, off-package communication bandwidth is expected to improve by 1-2 times over the next decade. Unlike current pluggable optics, this technology integrates electronic and optical components within millimeters, shortening signal distance and providing better power efficiency.

Potential for Quantum Computing Collaboration

NVIDIA is building a CUDA quantum system through a system called CUDA-Q, designed to be supported across various platforms. At the GTC event, several quantum computing-related companies are expected to participate, introducing their technologies and emphasizing the importance of hybrid computing.

NVIDIA is positioned to support quantum computers handling the rapid processing portions of conventional computing, potentially leading to dramatic performance improvements in specific computations. Technologies like robotics are also likely to develop based on these systems in the future.

Conclusion: NVIDIA's Future Strategy and AI Market Leadership

NVIDIA is expected to further strengthen its leadership in the AI market through the B300 GPU, innovative cooling technologies, advanced packaging technologies, FP4 computation, and changes in data center infrastructure. These technological innovations have the potential to transform the paradigm of the entire AI ecosystem beyond simply improving performance.

Particularly noteworthy is that NVIDIA is not simply responding to current demand but is taking a proactive strategy that predicts and prepares for future demands 2-3 years ahead. This approach will be a key factor for NVIDIA to maintain a continuous competitive edge in the rapidly changing AI technology environment.

In conclusion, NVIDIA GTC 2025 is expected to be an important milestone beyond a simple new product announcement event, offering a glimpse into the future of AI technology and changes in computing paradigms. The innovative technologies to be announced at this event will fundamentally change how we view computing and AI.

관련 태그

#NVIDIA #GTC2025 #B300GPU #AI기술 #패키징기술 #CoWoS #액체냉각 #FP4 #데이터센터 #퀀텀컴퓨팅 #엔비디아 #인공지능 #딥러닝 #하이퍼컴퓨팅 #반도체기술 #HBM #멀티칩모듈 #COPA #광학인터커넥트 #궈밍치

Citations:

- https://arxiv.org/pdf/2301.03592.pdf

- https://ar5iv.labs.arxiv.org/html/2310.09568

- https://openreview.net/attachment?id=7INDR2BSwa&name=pdf

- https://ar5iv.labs.arxiv.org/html/2104.02188

- https://arxiv.org/pdf/2307.08060.pdf

- https://arxiv.org/html/2501.10187v1

- https://arxiv.org/pdf/2501.10187.pdf

- https://ar5iv.labs.arxiv.org/html/2310.11651

- https://arxiv.org/html/2312.16436v1

- https://arxiv.org/html/2406.00858v1

- https://arxiv.org/html/2405.14821v1

'DeepResearch' 카테고리의 다른 글

| 🧠 액체 신경망: 벌레의 뇌에서 영감받은 AI의 혁명적 진화 (2) | 2025.03.18 |

|---|---|

| 바이두의 무료 AI 혁명: Ernie 4.5와 Ernie X1로 AI 기술의 민주화를 선도하다 (0) | 2025.03.17 |

| 2025년 AI 혁신의 물결: Manus AI, 바이브 코딩, AI 폰이 바꾸는 미래 (0) | 2025.03.17 |

| 금융의 미래를 재편하는 AI: JP모건 CEO 제이미 다이먼의 AI 비전과 전략 (0) | 2025.03.16 |

| 📱 AI 에이전트 대격변: OpenAI의 '도구와 API'가 바꾸는 디지털 세상 (2025년 최신 기술 총정리) (0) | 2025.03.15 |