AI와의 소통을 최적화하는 프롬프트 엔지니어링이 왜 주목받고 있는지, 국내 1호 프롬프트 엔지니어인 강수진 대표의 통찰력을 통해 살펴봅니다. 생성형 AI 시대에 서비스의 성공을 좌우하는 프롬프트 엔지니어링의 핵심 전략과 기법, 그리고 2025년 미래 전망까지 실무 중심으로 탐색합니다.

프롬프트 엔지니어링 어디까지 가능할까? (강수진 박사)

이 영상은 강수진 대표가 프롬프트 엔지니어링의 **가능성**과 **실제 사례**를 소개합니다. 프롬프트 엔지니어링은 AI와의 **소통 도구**인 프롬프트를 통해 다양한 산업 분야에서 **생성형 AI 서

lilys.ai

프롬프트 엔지니어링: AI와의 소통을 위한 필수 역량

프롬프트 엔지니어링은 단순한 프롬프트 작성 기술을 넘어 AI 서비스의 성공을 위한 핵심 역량으로 자리잡고 있습니다. 강수진 대표는 프롬프트를 "AI와의 도구"로 정의하며, 프롬프트 설계에 따라 결과물이 크게 달라짐을 강조합니다^1.

프롬프트 엔지니어링의 중요성

생성형 AI 시대에 프롬프트 엔지니어링이 주목받는 이유는 분명합니다. 프롬프트는 경험의 과학으로, 어떤 언어 모델을 사용하더라도 프롬프트가 시작점으로서 중요한 역할을 합니다^1. 언어 모델의 결과값은 프롬프트의 작성 및 활용 방식에 따라 천차만별로 달라지므로, 프롬프트 설계는 성능에 결정적 영향을 미칩니다^1.

![프롬프트 엔지니어링의 정의와 중요성을 시각화한 이미지]

강수진 대표는 프롬프트 엔지니어링의 가치를 다음과 같이 설명합니다:

- 코드 없이 자연어로 접근: 프롬프트 엔지니어링을 통해 코딩 없이도 자연어로 모델에 접근하여 기능을 개발할 수 있습니다^1.

- 서비스 효용성 극대화: 적절한 프롬프트는 AI 서비스의 효용성을 극대화합니다^1.

- 경험적 가치: 프롬프트 엔지니어링은 경험을 통해 발전하는 과학입니다.

프롬프트 엔지니어의 역할은 프롬프트 제작, 무한 반복의 테스트, 파라미터 조정 및 최적화를 통해 안정적인 프로덕션 레벨까지 결과값을 조정하는 것입니다. 이러한 역할은 의료, 금융, 마케팅 등 다양한 산업 분야에서 중요하게 부각되고 있습니다.

AI 서비스의 문제점과 프롬프트 엔지니어링 해결책

생성형 AI 서비스가 직면한 주요 도전과제들은 프롬프트 엔지니어링을 통해 해결할 수 있습니다. 강수진 대표의 분석에 따르면, AI 서비스의 핵심 문제점과 해결책은 다음과 같습니다.

클라리티(명확성) 문제

AI 모델은 자연어를 잘 생성하지만, 내용이 명확하지 않고 수렴하지 못하는 경향이 있습니다[2.5]. 현재 모델들은 클라리티가 떨어지는 문제를 안고 있으며, 이는 사용자 경험에 부정적 영향을 미칩니다.

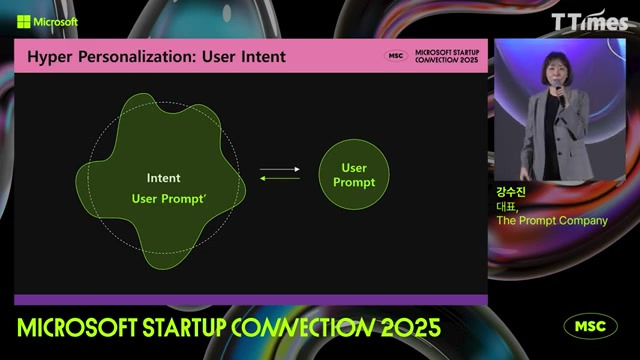

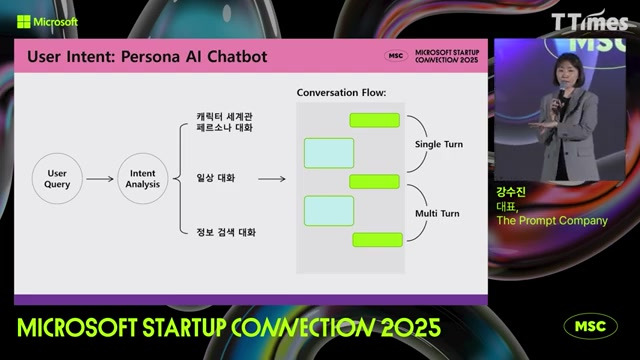

해결책: 사용자 의도를 정확히 파악하고 반영하는 프롬프트 설계가 필요합니다. 강수진 대표는 성공적인 생성형 AI 서비스의 핵심은 사용자 의도를 파악하는 것이라고 강조합니다^3. 사용자 의도 분석을 바탕으로 명확한 프롬프트를 설계하면 AI의 응답 품질을 높일 수 있습니다.

맥락 유지 문제

멀티턴 대화에서 AI가 이전 대화의 맥락을 유지하지 못하는 문제가 있습니다^4. 이로 인해 사용자는 반복적으로 정보를 제공해야 하는 불편함을 겪게 됩니다.

해결책: 멀티턴 대화에서 정보를 보존하는 방법으로 싱글 턴과 멀티턴을 구분해 처리하고, 의도 분석을 기반으로 한 카테고리화가 필요합니다^4. 별표 기호 등을 활용해 문장을 구분하는 방법도 자연어의 모호함을 해결하는 데 도움이 됩니다.

![맥락 유지를 위한 프롬프트 설계 예시]

일관성(컨시스턴시) 문제

모델의 일관성이 떨어지는 컨시스턴시 문제는 AI 서비스의 신뢰도를 저하시킵니다. 같은 질문에 다른 답변을 하거나, 대화 중 스타일이 변하는 등의 문제가 발생합니다.

해결책: 최근 LLM에서는 메모리 증폭과 프롬프트 리유즈를 통해 효율성을 높이는 연구가 활발하게 진행되고 있습니다. 멀티 에이전트 코드를 구성할 때 프롬프트 엔지니어링이 필수적이며, 다양한 기능을 가진 에이전트들의 결합으로 일관성을 높일 수 있습니다.

비용 효율성 문제

AI 모델 사용 비용은 토큰 수에 비례하므로, 긴 프롬프트는 비용 부담으로 이어집니다^5. 특히 기업 환경에서는 비용 효율성이 중요한 고려사항입니다.

해결책: 짧지만 효과적인 프롬프트를 사용하는 것이 중요합니다. 코스트 절감을 위해 LLM을 여러 번 호출하는 대신 한 번만 호출하는 제로샷 형태의 프롬프트를 사용하는 것이 효과적입니다. 토큰 수를 줄이되 결과의 질은 유지하는 프롬프트 최적화가 필요합니다.

할루시네이션 문제

AI가 사실이 아닌 정보를 생성하는 할루시네이션 문제는 신뢰성에 큰 타격을 줍니다. 이는 특히 의료, 법률, 금융과 같은 정확성이 중요한 분야에서 심각한 문제입니다.

해결책: 추론 모델은 리즈닝을 기반으로 하며, 사고 과정을 거쳐 답변의 정확성을 높입니다. 랭그래프 개념을 도입해 순환 구조로 피드백을 통해 모델의 잘못된 방향을 수정할 수 있습니다. 이를 통해 할루시네이션을 줄이고 정확도를 높일 수 있습니다.

프롬프트 엔지니어링의 발전 과정: 초기 문장 작성부터 멀티 에이전트까지

프롬프트 엔지니어링은 단순한 문장 작성 기술에서 복잡한 시스템 설계로 빠르게 진화해왔습니다. 강수진 대표는 이러한 발전 과정을 다음과 같이 설명합니다.

초기 단계: 기본 문장 작성

초기 프롬프트 엔지니어링은 단순히 문장을 잘 쓰는 것으로 인식되었습니다. 국내에서는 프롬프트에 대한 인식이 낮았으며, 단순 문장 작성으로 제한되어 있는 경향이 있었습니다.

중간 단계: 구조화된 프롬프트

단순 문장에서 벗어나 구조화된 프롬프트가 등장했습니다. 하이어 인포메이티브 스트럭처는 정보를 구조적으로 배치하여 LLM의 응답 품질을 향상시키는 방법으로 발전했습니다. 각 LLM마다 선호하는 프롬프트 구조와 기호가 다르다는 것이 발견되었고, 이에 맞춘 최적화가 이루어졌습니다.

![프롬프트 엔지니어링의 발전 단계를 보여주는 타임라인]

고급 단계: 체인 오브 탓과 슬로우 씽킹

더 복잡한 프롬프트 기법들이 개발되었습니다. 체인 오브 탓은 사고를 연장하는 기법으로, 모델을 더 깊이 사고하게 만드는 방법입니다. "슬로우 씽킹"이라는 개념은 연상 과정을 늘려 모델의 성능을 향상시키는 데 기여했습니다.

현재: 랭체인과 멀티 에이전트

현재는 랭체인, 랭그래프, 멀티에이전트와 같은 유행하는 키워드가 등장했습니다. LangGraph(랭그래프)는 에이전트와 도구의 처리를 노드로 표현하고 노드 간의 연결을 엣지로 표현하는 방식으로, 복잡한 제어구조를 가진 워크플로우를 유연하게 표현할 수 있게 해줍니다^12.

멀티 에이전트 시스템에서는 다양한 기능을 가진 여러 에이전트를 결합하는 것이 핵심이며, 이를 위해 프롬프트 엔지니어링이 필수적입니다. 예를 들어, 소프트웨어 개발팀을 멀티에이전트로 구현할 때 리더, 프로그래머, 테스터, 평가자의 4가지 에이전트가 서로 협력하여 작업을 수행합니다^12.

미래 방향: 자동화와 최적화

프롬프트 엔지니어링의 발전은 자동화와 최적화 방향으로 진행되고 있습니다. 자동 프롬프트 엔지니어링(APE)은 프롬프트 제작 과정을 자동화하여 효율성을 높이는 방향으로 발전하고 있습니다^6. 또한 구조적 프롬프트 설계 프레임워크인 LangGPT와 같은 도구들이 개발되고 있습니다^7.

다양한 프롬프트 엔지니어링 기법 비교 분석

강수진 대표는 다양한 프롬프트 엔지니어링 기법들을 소개하고 비교 분석합니다. 각 기법의 특성과 적용 상황을 이해하는 것이 중요합니다.

턴 청킹(Turn Chunking)

강수진 대표는 사용자와 AI의 상호작용을 싱글 턴과 멀티턴으로 구분해 분석하는 접근법을 소개합니다. 싱글 턴은 단일 질의-응답을, 멀티턴은 대화의 연속성을 분석합니다.

장점: 대화의 맥락을 유지하고 사용자 의도를 정확히 파악할 수 있습니다.

적용 사례: 챗봇 서비스, 고객 상담 시스템 등에 효과적입니다.

액션 포메이션과 액션 디스크립션

사용자 의도를 보다 다채롭게 분석하기 위한 기법으로, 액션 포메이션은 사용자가 하고자 하는 행위를 설명하고, 액션 디스크립션은 숨겨진 의도를 밝히는 방식입니다.

장점: 표면적인 요청 너머의 실제 사용자 의도를 파악할 수 있습니다.

적용 사례: "주식 동향"과 같이 모호한 프롬프트의 의도를 파악할 때 유용합니다.

![액션 포메이션과 액션 디스크립션 비교 다이어그램]

메타프롬프트

메타프롬프트는 LLM이 필요한 프롬프트를 자동으로 생성하는 개념으로, 프롬프트 작성의 번거로움을 줄여줍니다.

장점: 사용자는 간단한 요청만 하면 LLM이 적절한 프롬프트를 구성합니다.

적용 사례: 프롬프트 작성 경험이 부족한 일반 사용자들에게 유용합니다.

스케폴딩 구조

위계 질서를 잡는 스케폴딩 구조를 활용하여 LLM의 발산과 수렴을 효과적으로 유도하는 기법입니다.

장점: 체계적인 정보 처리와 구조화된 응답을 생성할 수 있습니다.

적용 사례: 복잡한 정보 요약, 단계적 문제 해결 등에 효과적입니다.

체인 오브 탓(Chain of Thought)

사고를 연장하는 기법으로, 모델이 중간 추론 과정을 거쳐 최종 결론에 도달하도록 유도합니다^6.

장점: 복잡한 문제 해결능력 향상, 추론 과정의 투명성 제공

적용 사례: 수학 문제, 논리 퍼즐, 복잡한 의사결정 상황에 적합합니다.

슬로우 씽킹(Slow Thinking)

연상 과정을 늘려 모델의 성능을 향상시키는 기법으로, 모델이 더 깊이 사고하도록 유도합니다.

장점: 성급한 결론을 피하고 더 정교한 답변 생성 가능

적용 사례: 심층적 분석이 필요한 문제, 윤리적 판단이 요구되는 상황에 효과적입니다.

랭그래프(LangGraph)

복잡한 제어구조를 가진 워크플로우를 유연하게 표현할 수 있는 기술로, 노드와 엣지를 활용한 그래프 구조를 채택합니다^12.

장점: 반복 처리, 분기 처리 등 복잡한 워크플로우 표현 가능

적용 사례: 멀티에이전트 시스템, 자연어 쉘 인터페이스, 복잡한 대화형 애플리케이션 구현에 적합합니다^12.

![랭그래프를 활용한 워크플로우 예시]

2025년 프롬프트 엔지니어링의 미래 전망

강수진 대표의 경험과 통찰을 바탕으로, 2025년과 그 이후의 프롬프트 엔지니어링 발전 방향에 대한 전망을 제시합니다.

자동화된 프롬프트 최적화

강수진 대표는 프롬프트 자동화가 중요해지는 추세를 언급하며, 사용자들이 프롬프트 사용을 귀찮아하는 문제를 해결할 필요가 있다고 지적합니다. 자동 프롬프트 엔지니어링(APE)과 같은 기술이 더욱 발전하여, 사용자 의도를 자동으로 분석하고 최적의 프롬프트를 생성하는 시스템이 보편화될 것입니다^6.

멀티 에이전트 시스템의 확산

멀티 에이전트 시스템은 2025년 이후 AI 애플리케이션의 핵심 구성 요소가 될 것입니다. 강수진 대표는 멀티 에이전트 코드를 구성할 때 프롬프트 엔지니어링이 필수적이라고 강조합니다. 다양한 기능을 가진 여러 에이전트를 결합하는 것이 복잡한 AI 시스템 구축의 핵심이 될 것입니다^5.

안전성과 거버넌스 강화

세이프티와 거버넌스 강화를 통해 프롬프트 엔지니어링의 효과를 높이는 것이 중요하다는 점이 더욱 부각될 것입니다. AI 시스템의 윤리적, 법적 책임이 강조됨에 따라, 프롬프트 엔지니어링에도 안전장치와 규제 준수 메커니즘이 통합될 것입니다.

![2025년 프롬프트 엔지니어링의 발전 방향 다이어그램]

범용적 프롬프트 구조의 등장

다양한 LLM이 등장함에 따라, 보편적으로 잘 작동하는 구조의 프롬프팅이 필요해질 것입니다. 각기 다른 AI 모델에서도 일관된 성능을 보장하는 표준화된 프롬프트 구조와 패턴이 발전할 것입니다.

도메인 특화 프롬프트 엔지니어링

일반적인 프롬프트 기법과 함께, 의료, 법률, 금융 등 특정 도메인에 최적화된 프롬프트 엔지니어링 기법이 발전할 것입니다. 이는 각 분야의 전문성과 정확성을 높이는 데 기여할 것입니다.

프롬프트 엔지니어의 역할 확대

강수진 대표의 경험에서 볼 수 있듯이, 프롬프트 엔지니어의 역할과 중요성은 계속해서 확대될 것입니다. 특히, 언어학적 배경과 기술적 이해를 겸비한 전문가의 가치가 더욱 높아질 것입니다^3.

결론: 프롬프트 엔지니어링의 미래를 준비하며

강수진 대표가 강조하듯, 프롬프트 엔지니어링은 경험에 기반한 과학입니다. 사용자가 경험한 만큼 성과가 있으며, 실패를 통한 학습이 필수적입니다. 프롬프트 엔지니어링은 단순한 문장 작성 기술이 아닌, AI 서비스의 성공을 위한 핵심 역량으로 자리매김하고 있습니다^1.

생성형 AI 기술이 발전하고 활용 범위가 확대됨에 따라, 프롬프트 엔지니어링의 중요성은 더욱 커질 것입니다. 사용자 의도 분석, 맥락 유지, 일관성 확보, 비용 효율성 등의 측면에서 프롬프트 엔지니어링은 AI 서비스의 품질과 성능을 결정짓는 핵심 요소로 작용할 것입니다.

강수진 대표가 이끄는 The Prompt Company와 같은 전문 기업들의 등장과 성장은 프롬프트 엔지니어링이 하나의 산업으로 자리잡고 있음을 보여줍니다. 또한, 프롬프트 엔지니어링 교육의 확대와 체계화는 더 많은 전문가 양성으로 이어질 것입니다.

생성형 AI 시대에 프롬프트 엔지니어링은 기술과 인간의 소통을 연결하는 가교 역할을 계속해 나갈 것입니다. 많은 시도와 경험을 통해 생성형 AI LLM의 제대로 된 활용 방법을 익히는 것이 무엇보다 중요한 시대가 되었습니다.

#프롬프트엔지니어링 #강수진박사 #생성형AI #LLM #프롬프트최적화 #사용자의도분석 #멀티에이전트 #랭그래프 #체인오브탓 #AI서비스 #프롬프트엔지니어 #ThePromptCompany #AI기술 #프롬프트설계 #AI개발 #인공지능 #프롬프트자동화 #AI서비스최적화 #2025년AI전망

Insights from CEO Sujin Kang on Prompt Engineering: Strategies for Success in Generative AI Services

This article explores why prompt engineering, the art of optimizing communication with AI, is gaining attention through the insights of Sujin Kang, Korea's first prompt engineer. We delve into core strategies and techniques of prompt engineering that determine the success of services in the generative AI era, along with future prospects for 2025, all from a practical perspective.

Prompt Engineering: Essential Capability for AI Communication

Prompt engineering has established itself as a core competency for AI service success, beyond simple prompt writing techniques. CEO Sujin Kang defines prompts as "tools for AI interaction," emphasizing that results vary greatly depending on prompt design^1.

The Importance of Prompt Engineering

The reasons why prompt engineering is receiving attention in the generative AI era are clear. Prompts are a science of experience, playing a critical starting role regardless of which language model is used^1. Language model outputs vary tremendously depending on how prompts are written and utilized, making prompt design decisively influential on performance^1.

![Image visualizing the definition and importance of prompt engineering]

CEO Kang explains the value of prompt engineering as follows:

- Natural Language Access Without Coding: Prompt engineering enables feature development through natural language access to models without coding^1.

- Maximizing Service Utility: Appropriate prompts maximize the effectiveness of AI services^1.

- Experiential Value: Prompt engineering is a science that develops through experience.

The role of a prompt engineer involves creating prompts, conducting repeated testing, adjusting parameters, and optimizing to calibrate results to a stable production level. This role is becoming increasingly important across various industries including healthcare, finance, and marketing.

AI Service Challenges and Prompt Engineering Solutions

Generative AI services face key challenges that can be addressed through prompt engineering. According to CEO Kang's analysis, the core problems and solutions are as follows.

Clarity Issues

AI models generate natural language well, but tend to lack clarity and fail to converge[2.5]. Current models struggle with clarity issues, negatively impacting user experience.

Solution: Prompt design that accurately identifies and reflects user intent is necessary. CEO Kang emphasizes that the key to successful generative AI services is understanding user intent^3. Designing clear prompts based on user intent analysis can improve AI response quality.

Context Maintenance Issues

In multi-turn conversations, AI often fails to maintain the context of previous exchanges^4. This forces users to repeatedly provide the same information.

Solution: Methods for preserving information in multi-turn conversations include processing single turns and multi-turns separately, with categorization based on intent analysis^4. Using symbols like asterisks to separate sentences also helps resolve natural language ambiguities.

![Example of prompt design for maintaining context]

Consistency Issues

Consistency problems, where models lack coherence, reduce AI service reliability. Issues include providing different answers to the same question or changing conversation style mid-dialogue.

Solution: Recent LLM research actively focuses on improving efficiency through memory amplification and prompt reuse. Prompt engineering is essential when configuring multi-agent code, and combining agents with diverse capabilities can enhance consistency.

Cost Efficiency Issues

AI model usage costs are proportional to token count, so lengthy prompts lead to increased expenses^5. Cost efficiency is an important consideration, especially in business environments.

Solution: Using short but effective prompts is crucial. For cost reduction, zero-shot prompts that call the LLM once instead of multiple times are effective. Prompt optimization that reduces token count while maintaining result quality is necessary.

Hallucination Issues

The hallucination problem, where AI generates factually incorrect information, severely impacts reliability. This is especially serious in fields where accuracy is critical, such as healthcare, legal, and finance.

Solution: Reasoning-based inference models improve answer accuracy through thought processes. Implementing the LangGraph concept enables feedback through circular structures to correct model errors. This can reduce hallucinations and increase accuracy.

Evolution of Prompt Engineering: From Basic Sentence Construction to Multi-Agent Systems

Prompt engineering has rapidly evolved from simple sentence construction to complex system design. CEO Kang explains this developmental process as follows.

Initial Stage: Basic Sentence Construction

Early prompt engineering was perceived simply as writing good sentences. In Korea, awareness of prompts was low, with a tendency to limit them to simple sentence construction.

Intermediate Stage: Structured Prompts

Moving beyond simple sentences, structured prompts emerged. Higher informative structure developed as a method to improve LLM response quality by structurally arranging information. It was discovered that each LLM has different preferred prompt structures and symbols, leading to optimizations accordingly.

![Timeline showing the developmental stages of prompt engineering]

Advanced Stage: Chain of Thought and Slow Thinking

More complex prompt techniques were developed. Chain of Thought is a technique that extends thinking, making models think more deeply. The concept of "Slow Thinking" contributed to improving model performance by extending the association process.

Present: LangChain and Multi-Agent Systems

Currently, trending keywords like LangChain, LangGraph, and multi-agent have emerged. LangGraph represents agent and tool processing as nodes and connections between nodes as edges, enabling flexible representation of workflows with complex control structures^12.

In multi-agent systems, combining various agents with different functionalities is key, requiring prompt engineering. For example, when implementing a software development team as multi-agents, four agents—leader, programmer, tester, and evaluator—collaborate to perform tasks^12.

Future Direction: Automation and Optimization

Prompt engineering development is progressing toward automation and optimization. Automatic Prompt Engineering (APE) is evolving to improve efficiency by automating the prompt creation process^6. Tools like LangGPT, a structured prompt design framework, are also being developed^7.

Comparative Analysis of Various Prompt Engineering Techniques

CEO Kang introduces and comparatively analyzes various prompt engineering techniques. Understanding the characteristics and application contexts of each technique is important.

Turn Chunking

CEO Kang introduces an approach that analyzes interactions between users and AI by distinguishing between single turns and multi-turns. Single turns analyze individual query-response pairs, while multi-turns analyze conversation continuity.

Advantages: Maintains conversation context and accurately identifies user intent.

Application Cases: Effective for chatbot services, customer support systems, etc.

Action Formation and Action Description

Techniques for analyzing user intent more richly, where action formation explains what the user wants to do, and action description reveals hidden intentions.

Advantages: Can identify actual user intent beyond surface-level requests.

Application Cases: Useful for interpreting ambiguous prompts like "stock trends".

![Comparative diagram of action formation and action description]

Meta-Prompt

Meta-prompt is a concept where LLMs automatically generate necessary prompts, reducing the burden of prompt writing.

Advantages: Users make simple requests and the LLM constructs appropriate prompts.

Application Cases: Useful for general users with limited prompt writing experience.

Scaffolding Structure

A technique that effectively guides LLM divergence and convergence using hierarchical scaffolding structures.

Advantages: Enables systematic information processing and structured responses.

Application Cases: Effective for complex information summarization, step-by-step problem solving, etc.

Chain of Thought

A thought-extending technique that guides models to reach final conclusions through intermediate reasoning processes^6.

Advantages: Improves complex problem-solving abilities, provides transparency in reasoning processes.

Application Cases: Suitable for mathematical problems, logic puzzles, and complex decision-making situations.

Slow Thinking

A technique that improves model performance by extending the association process, encouraging deeper thinking.

Advantages: Avoids hasty conclusions and enables generation of more sophisticated answers.

Application Cases: Effective for problems requiring in-depth analysis and situations requiring ethical judgment.

LangGraph

A technology that flexibly represents workflows with complex control structures, adopting a graph structure using nodes and edges^12.

Advantages: Enables representation of complex workflows including repetitive processing and branching.

Application Cases: Suitable for implementing multi-agent systems, natural language shell interfaces, and complex interactive applications^12.

![Example workflow using LangGraph]

Future Outlook for Prompt Engineering in 2025

Based on CEO Kang's experience and insights, this section presents prospects for prompt engineering development directions in 2025 and beyond.

Automated Prompt Optimization

CEO Kang mentions the increasing importance of prompt automation and the need to address users' reluctance to use prompts. Technologies like Automatic Prompt Engineering (APE) will further develop, creating systems that automatically analyze user intent and generate optimal prompts^6.

Proliferation of Multi-Agent Systems

Multi-agent systems will become core components of AI applications after 2025. CEO Kang emphasizes that prompt engineering is essential when configuring multi-agent code. Combining various agents with different functionalities will be key to building complex AI systems^5^11.

Enhanced Safety and Governance

The importance of strengthening safety and governance to enhance prompt engineering effectiveness will be increasingly emphasized. As ethical and legal responsibilities of AI systems are highlighted, safety mechanisms and regulatory compliance will be integrated into prompt engineering.

![Diagram of prompt engineering development directions for 2025]

Emergence of Universal Prompt Structures

With various LLMs emerging, universally effective prompt structures will become necessary. Standardized prompt structures and patterns that ensure consistent performance across different AI models will develop.

Domain-Specific Prompt Engineering

Alongside general prompt techniques, prompt engineering techniques optimized for specific domains like healthcare, legal, and finance will develop. This will contribute to enhancing expertise and accuracy in each field.

Expanded Role of Prompt Engineers

As seen in CEO Kang's experience, the role and importance of prompt engineers will continue to expand. Particularly, the value of experts combining linguistic backgrounds with technical understanding will increase^3.

Conclusion: Preparing for the Future of Prompt Engineering

As CEO Kang emphasizes, prompt engineering is a science based on experience. Results come from user experience, and learning through failure is essential. Prompt engineering has established itself as a core competency for AI service success, beyond simple sentence writing techniques^1.

As generative AI technology develops and its application range expands, the importance of prompt engineering will grow. In terms of user intent analysis, context maintenance, consistency assurance, and cost efficiency, prompt engineering will act as a core element determining AI service quality and performance.

The emergence and growth of specialized companies like The Prompt Company, led by CEO Kang, shows that prompt engineering is establishing itself as an industry. Additionally, the expansion and systematization of prompt engineering education will lead to training more experts.

In the generative AI era, prompt engineering will continue its role as a bridge connecting technology and human communication. It has become more important than ever to learn proper utilization methods for generative AI LLMs through numerous attempts and experiences.

#PromptEngineering #DrSujinKang #GenerativeAI #LLM #PromptOptimization #UserIntentAnalysis #MultiAgent #LangGraph #ChainOfThought #AIServices #PromptEngineer #ThePromptCompany #AITechnology #PromptDesign #AIDevelopment #ArtificialIntelligence #PromptAutomation #AIServiceOptimization #2025AIOutlook

#프롬프트엔지니어링 #강수진박사 #생성형AI #LLM #프롬프트최적화 #사용자의도분석 #멀티에이전트 #랭그래프 #체인오브탓 #AI서비스 #프롬프트엔지니어 #ThePromptCompany #AI기술 #프롬프트설계 #AI개발 #인공지능 #프롬프트자동화 #AI서비스최적화 #2025년AI전망

'DeepResearch' 카테고리의 다른 글

| AI 비디오 혁명: 클링 AI 2.0과 첨단 콘텐츠 제작 기술의 등장 (0) | 2025.04.17 |

|---|---|

| 제타(Zeta): LLM이 개척하는 새로운 인터랙티브 스토리텔링의 세계 (0) | 2025.04.13 |

| DeepSeek GRM: 자가 학습으로 GPT-4o를 능가하는 혁신적 AI 모델 (0) | 2025.04.12 |

| 미래를 선도하는 혁신의 키워드: 마이크로소프트 스타트업 커넥션 2025에서 본 AI 피보팅 전략 (0) | 2025.04.12 |

| AI 시대의 개발자 생존 전략: 코파일럿에서 시스템 통합까지 (0) | 2025.04.11 |